Ett avancerat datasystem som använder sig av artificiell intelligens för att bedöma sannolikheten för att någon ska återfalla i brott pekar ut svarta människor som mer kriminella än de faktiskt är. Det konstateras i en färsk rapport som publicerats i Science.

Programmet heter Correctional Offender Management Profiling for Alternative Sanctions, eller Compas. Det används sedan några år tillbaka av bland annat polismyndigheter och domstolar i USA för att bedöma sannolikheten för att en brottsling ska återfalla i brottslighet.

Syftet är att utdöma lämpliga påföljder, sätta in rätt åtgärder efter avtjänat straff och optimera rättsväsendet så att de som utgör det största hotet mot samhället förblir inlåsta medan de som bedöms utgöra en lägre risk kan få mildare påföljder eller erbjudas villkorliga frigivningar och straff.

Compas använder sig av ett slags artificiell intelligens och utgår ifrån hundratusentals rättsfall för att ”lära sig” att känna igen vilka brottslingar som löper störst risk att återfalla i brott. Den som använder programmet får på en tiogradig skala (1-10) veta hur pass stor risken är att den misstänkte eller dömde brottslingen kommer begå nya brott.

Åtminstone är det så det är tänkt att programmet ska fungera.

Topphemlig kod

De senaste åren har Compas mött växande kritik. Bland annat handlar kritiken om bristande insyn i hur datasystemet fungerar. En brottsling som av Compas bedömts utgöra en hög risk får aldrig veta på vilka grunder denna bedömning gjorts. Företaget som utvecklat det, Northpointe, vill inte avslöja hur programmets kod ser ut eftersom de betraktar den informationen som en företagshemlighet.

I maj 2016 publicerade Pulitzer-belönade ProPublica en artikel där de jämförde ett stort antal rättsfall för att se hur bra Compas var på att bedöma återfallsrisker. ProPublica skriver i artikeln att den artificiella intelligensen i Compas i större utsträckning bedömer svarta som ”hög risk” än vita.

Bland annat tar ProPublica upp flera exempel på vita förövare som bedömts ha en ”låg risk” att återfalla i brottslighet men trots det gjort det. Omvänt tas exempel upp på svarta brottslingar som bedömts ha en ”hög risk” att begå nya brott, men som levt laglydigt efter senaste domen.

ProPublica nämner även exempel där domare låtit sig påverkas av Compas riskbedömningar och dömt ut hårdare straff än de annars skulle ha gjort, endast för att programmet hävdat att den åtalade haft en ”hög risk” att återfalla i brott.

Diskriminerar svarta?

Nu har en grupp forskare vid avdelningen för datavetenskap på Dartmouth College i Hanover, New Hampshire, kartlagt om det ligger något i anklagelserna som publicerades i ProPublica för snart två år sedan. Resultatet kan tyckas förvånande.

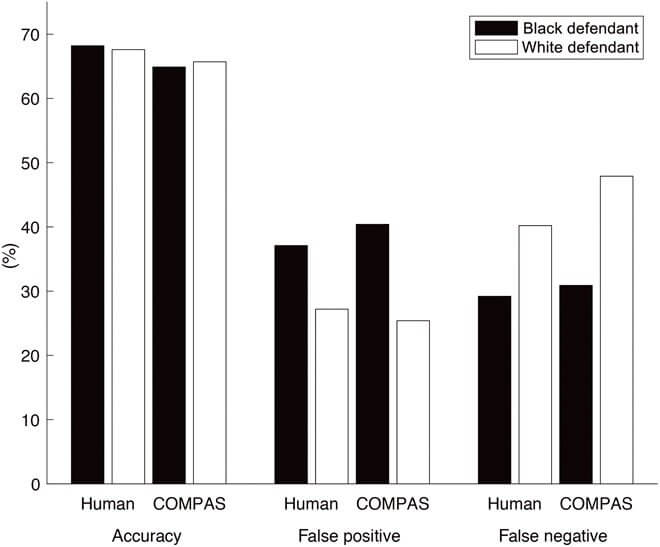

Det visar sig för det första att Compas är ungefär lika bra som en människa på att avgöra om en brottsling kommer återfalla i brottslighet eller inte. För det andra konstateras att den artificiella intelligensen i programmet pekar ut svarta som oproportionerligt mer benägna att återfalla i brottslighet jämfört med vita brottslingar.

Compas ”vet” inte vilka brottslingar som är vita och vilka som är svarta. Rastillhörighet ingår nämligen inte i den information som programmet får tillgång till. Alltså kan programmet omöjligen systematiskt diskriminera svarta brottslingar på grund av deras hudfärg.

Forskarna bakom rapporten i Science tror därför att det finns andra faktorer än ras, men som är relaterade till ras, som gör att Compas pekar ut svarta brottslingar som mer kriminella än de faktiskt är.